(llama 3.1 Meta) ميتا: لاما 3.1

هو إصدار حديث من شركة Meta AI، تمثل قفزة كبيرة للأمام في نماذج اللغات مفتوحة المصدر، (NLP) وتوليد النصوص Llama 3.1 لتقديم أداء متقدم في معالجة اللغة الطبيعية المستمرة لتحسين الذكاء الاصطناعي وتطوير تقنيات تعلم الآلة (Meta) هذا النموذج القوي في المجال مفتوح المصدر هو تغيير لقواعد تطوير تقنيات تعلم الآلة ويعد جزءًا من جهود بأداء عالي.

- الميزات الرئيسية

1. أداء عالي: تحسين دقة الفهم وتوليد النصوص بشكل ملحوظ مقارنةً بالإصدارات السابقة.

2. دعم متعدد اللغات: دعم متعدد اللغات يجعله مناسباً للتطبيقات العالمية.

3. السرعة والكفاءة: تم تحسين وقت الاستجابة والكفاءة، مما يجعله مناسباً للتطبيقات التفاعلية.4. التكامل السلس: سهولة التكامل مع مجموعة كبيرة من التطبيقات عبر واجهات برمجة التطبيقات والأطر المتاحة.

5. قدرات تعلُّم محسَّنة: قدرات تعلُّم عميقة محسَّنة وقابلة للتكيف مع مجموعة متنوعة من المهام.

- اللاما 3.1-405ب،(Llama 3.1 405B)

تم بناء Llama 3.1 405B على بنية Transformer القياسية لفك التشفير فقط، وهو تصميم مشترك للعديد من نماذج اللغات الكبيرة الناجحة, بينما يظل الهيكل الأساسي متسقًا، أدخلت ميتا تعديلات طفيفة لتعزيز استقرار النموذج وأدائه أثناء التدريب.

- دقة أعلى: من خلال معالجة الاستعلامات المتماثلة بشكل مشترك، يمكن للنموذج تحقيق دقة أعلى في فهم العلاقات بين الكلمات.

- توسعية أفضل: يمكن للنموذج التعامل مع نصوص أطول وأكثر تعقيدًا بفضل تحسين الكفاءة.اللاما3.1 هو نموذج لغة متقدم طورته ميتا .يمكن استخدام هذا النموذج في مجموعة متنوعة من التطبيقات، بما في ذلك إنشاء النص والإجابة على الأسئلة والترجمة الآلية .يصف هذا الدليل كيفية إعداد واستخداماللاما3.1 في بيئة برمجية.

قبل أن تبدأ ،تأكد من استيفاء المتطلبات الأساسية التالية:

بيئة البرمجيات: Python3.7 أو أعلى.

مكتبة إدارة الحزم: pip لتثبيت الحزم المطلوبة.

الوصول إلى المكتبة Meta لنموذج اللغة: إذا تم نشرها.

- خطوات التحضير

1. تثبيت المكتبات المطلوبة

أولاً، تحتاج إلى تثبيت المكتبات المطلوبة-إذا كانت مكتباتLlama 3.1 متوفرة عبر pip، يمكنك تثبيتها باتباع ا لخطوات التالية:يمكنك ضبط معلمات النموذج لتحسين الأداء أو التكيف مع متطلبات معينة. على سبيل المثال

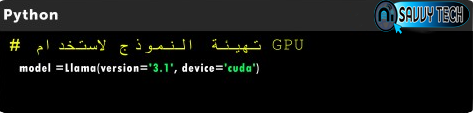

يمكنك تحسين سرعة النموذج باستخدامها (GPU)، إذا كان لديك جهاز يدعم وحدات معالجة الرسومات

- الخاتمة

Llama 3.1 يمثل قفزة نوعية في مجال معالجة اللغة الطبيعية بفضل هندسته المتقدمة وآليات التدريب الفعالة. من خلال استخدام بنية التحويلات والتدريب على كميات ضخمة من البيانات، يمكن للنموذج فهم وتوليد النصوص بشكل دقيق وفعال. هذا يجعله أداة قوية لتطبيقات متعددة مثل البحث، توليد المحتوى، والدعم الفني.

Llama 3.1 يمثل قفزة نوعية في مجال معالجة اللغة الطبيعية بفضل هندسته المتقدمة وآليات التدريب الفعالة. من خلال استخدام بنية التحويلات والتدريب على كميات ضخمة من البيانات، يمكن للنموذج فهم وتوليد النصوص بشكل دقيق وفعال. هذا يجعله أداة قوية لتطبيقات متعددة مثل البحث، توليد المحتوى، والدعم الفني.

التسميات

موقع والأدوات الذكاء الاصط